ChatGPT付费功能免费用,Mistral把Canvas、Artifact全复制了

ChatGPT付费功能免费用,Mistral把Canvas、Artifact全复制了欧洲的OpenAI,把ChatGPT功能都复制了。 Mistral AI大模型平台Le Chat新增Canvas、联网搜索、上传PDF等ChatGPT同款功能,而且全都免!费!

欧洲的OpenAI,把ChatGPT功能都复制了。 Mistral AI大模型平台Le Chat新增Canvas、联网搜索、上传PDF等ChatGPT同款功能,而且全都免!费!

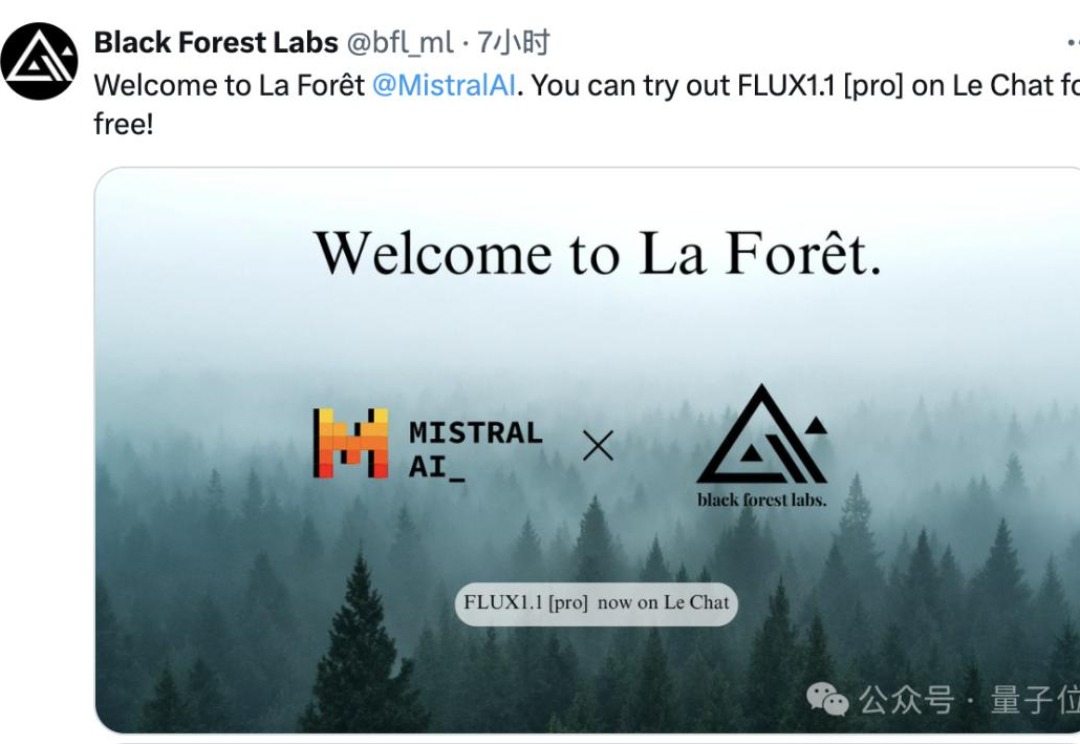

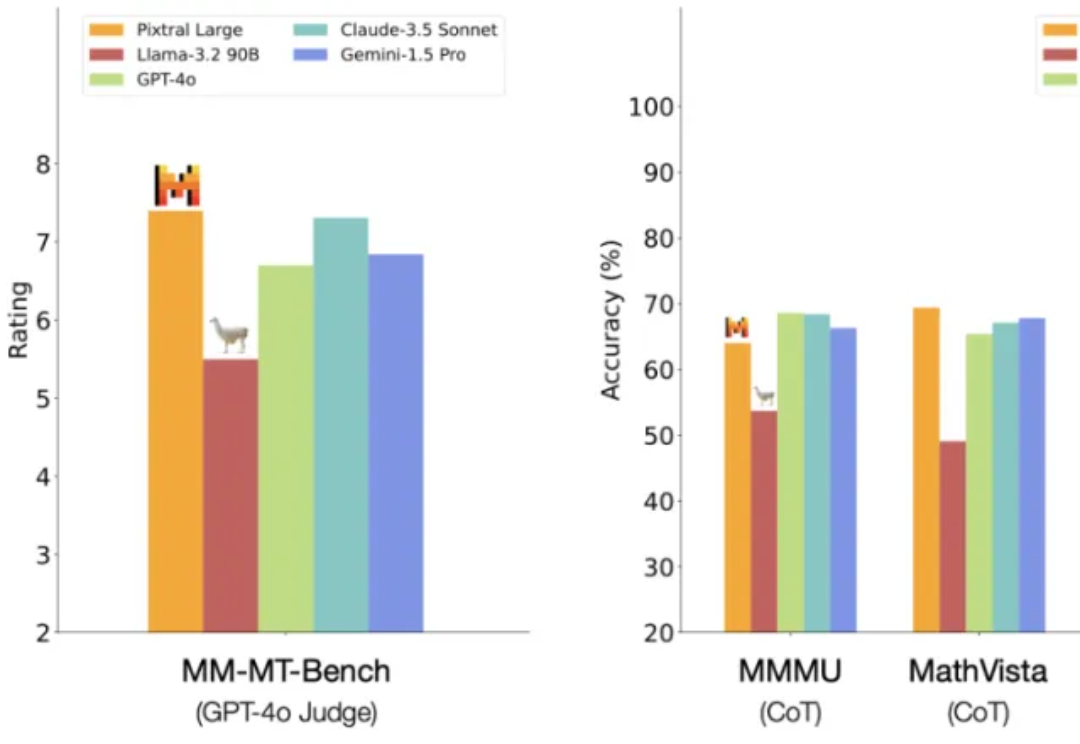

一觉醒来,Mistral AI 又发力了。 就在今天,Mistral AI 多模态家族迎来了第二位成员:一个名为 Pixtral Large 的超大杯基础模型。

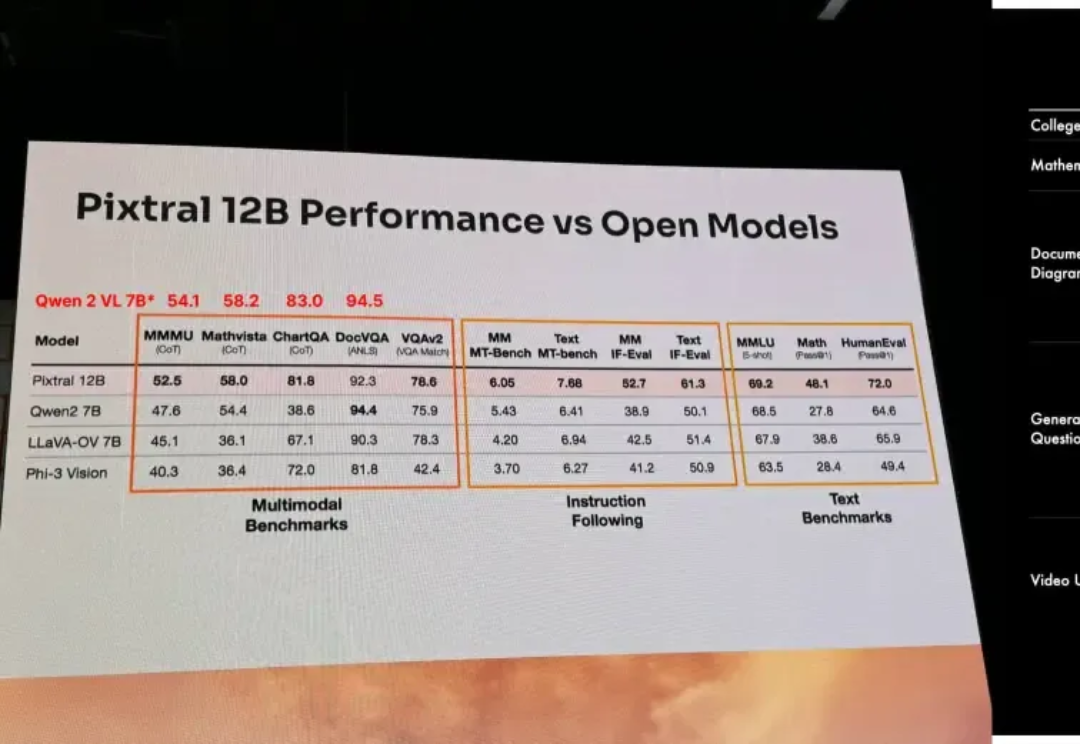

以开源极客之姿杀入江湖的Mistral AI,在9月份甩出了自家的首款多模态大模型Pixtral 12B,如今,报告之期已至,技术细节全公开。

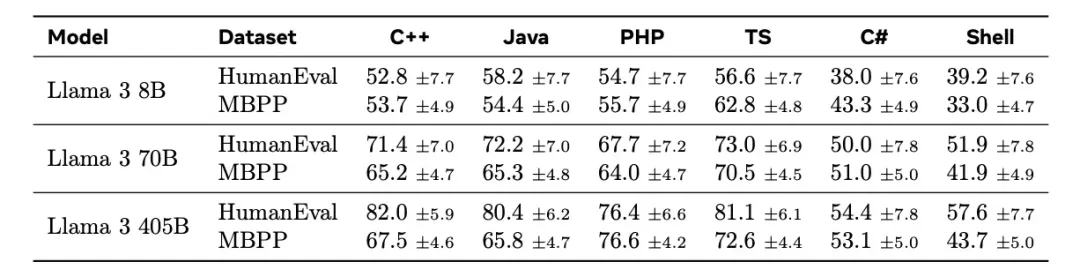

Mistral 7B诞生一周年之际,法国AI初创公司Mistral再次连发两个轻量级模型Ministral 3B和Ministral 8B,性能赶超Llama 3 8B。

Mistral AI盈利路径不明确,但其边缘AI模型性能超谷歌、Meta。

人工智能初创公司 Mistral 发布了其首个旨在运行在边缘设备上的生成式人工智能模型,如笔记本电脑和手机。

TII开源全球第一个通用的大型Mamba架构模型Falcon Mamba 7B,性能与Transformer架构模型相媲美,在多个基准测试上的均分超过了Llama 3.1 8B和Mistral 7B。

7 月,大模型公司 Cohere 宣布 D 轮融资 5 亿美元,估值 55 亿,比去年高了一倍多。 跟 OpenAI、Anthropic 甚至法国 AI 公司 Mistral 相比,成立于加拿大的 Cohere 略显低调,没有推出自己的 Chatbot、文生图或者文生视频产品,不涉足个人消费端产品;即使是推出的开源大模型 Command R+,似乎也没有那么引人注意。

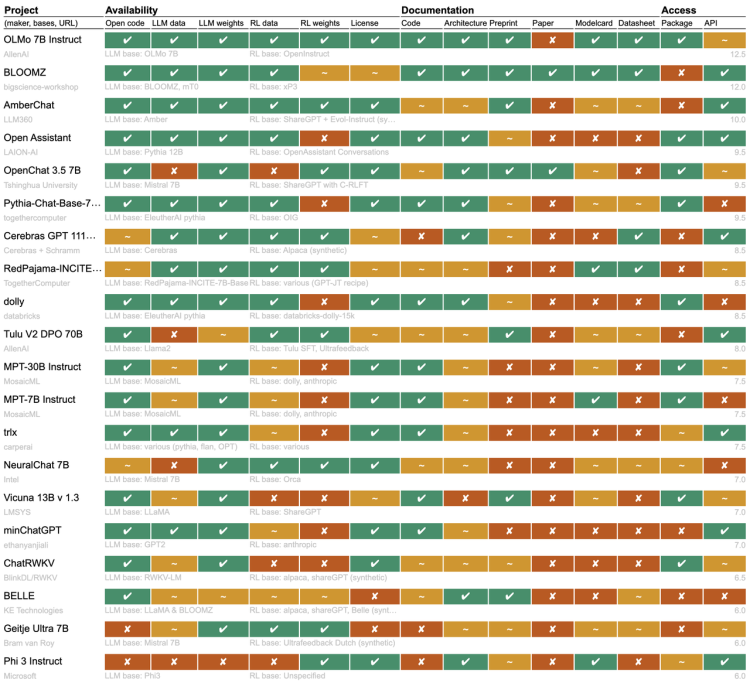

最近一段时间开源大模型市场非常热闹,先是苹果开源了70亿参数小模型DCLM,然后是重量级的Meta的Llama 3.1 和Mistral Large 2相继开源,在多项基准测试中Llama 3.1超过了闭源SOTA模型。 不过开源派和闭源派之间的争论并没有停下来的迹象。

最近两款大型 AI 模型相继发布。